Militarisierung über KI-Sprachmodelle und ‚soziale‘ Medien

Referent Christian Heck, KHM Köln / FIFF e.V.

Dienstag, 26.8.25 um 16:30 im Zirkuszelt

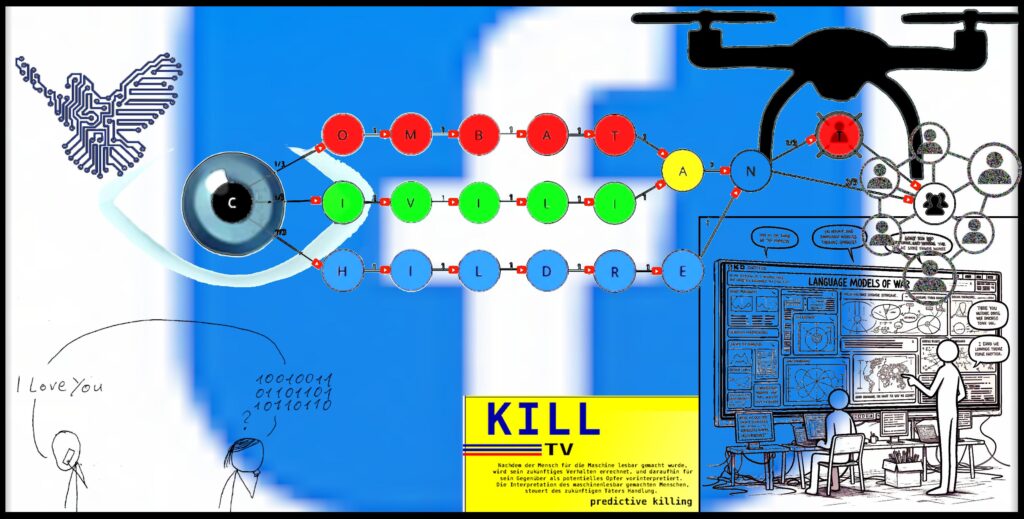

Die mediale Öffentlichkeit erfuhr am 25. März 2025 durch eine Recherche des Journalisten und Filmemachers Yuval Abraham im palästinensisch-israelischen Magazin +972 vom Ausmaß der Entwicklung künstlich intelligenter Chatbots zur militärischen Überwachung, Zielerfassung, sowie zur Vorbereitung und Durchführung militärischer Operationen. Seither müssen wir uns mit der Tatsache auseinandersetzen, dass KI-gestützte Battle-Management- und Entscheidungs-(Unterstützungs-)systeme wie beispielsweise „Lavender” im Gazastreifen mit KI-Sprachmodellen ausgestattet zum Einsatz kommen, wo sie von Soldat:innen auf die gleiche Weise bedient werden, wie ChatGPT von der Zivilbevölkerung im Lebens- und Arbeitsalltag. So wird ChatGPT zur tödlichen Waffe, die eine Realität erzeugt, in der über Leben und Tod entschieden wird.

Big-Tech-Monopole gestalten hierdurch nicht nur unseren zivilen Lebensalltag mit, sondern auch Krisen und Kriege unserer Zeit. Ihre „intelligenten“ Medientechnologien „lernen“ von unseren Social Media Posts abstrakte Gefahren zu berechnen, um sie dann präemptiv zu verhindern.

Eine gefährliche Sicherheits-, Militär- und BigData Logik, die durch eine gänzlich neue Art von technisch erzeugter Dehumanisierung zu unzähligen zivilen Opfern führt.

Opfer sogenannter „Targeted Killings“ mittels bewaffneter Drohnen, die nicht nur in Deutschland mitentwickelt, sondern auch von deutschem Boden aus gesteuert werden.

Der Drohnenkrieg im War on Terror markiert den Anfangspunkt für eine vorangegangene Technologisierung des Kriegs, der über eine zivil-militärische (dual use) Normalisierung die aggressiv-disruptive Gesellschaftsveränderung des Zivilen betrieb. Die derzeitige ‚Tiktokisierung‘ von Wanderungen und Mountainbike-Touren per Drohne trägt dabei durchaus zu einer Popularisierung von Drohneneinsätzen in der ‚Zeitenwende‘ bei. Drohnen-Startups präsentieren sich selbstbewusst als gesellschaftlich angesehene Unternehmen und erfreuen sich zweistelliger Milliardenbeträge an Risikokapital-Unterstützung.

Solch kriegerisch-zivile Innovationen durch Technologien lediglich über den „Werkzeug“-Charakter – also deren Nutzung (getrennt) im zivilen oder militärischen Bereich zu begreifen, führt zu einer unzureichenden Gesellschaftsanalyse à la ‚Technikfolgenabschätzung‘. Wir müssen die gesellschaftlichen Bedingungen, die eine Entwicklung spezifischer Technologien erst ermöglichen, mitbetrachten, um zu einem vollständigen Bild des technologischen Angriffs zu gelangen.

Was bedeutet eine solche (umfassende) Technologiekritik für unseren antimilitaristischen Widerstand einerseits und unser Verhältnis zu einer (remilitarisierten) BigTech-Industrie, die sich politisch extrem-rechts bis faschistoid präsentiert? Die Forderung nach einer Zivilklausel für die Forschung an Hochschulen ist hier nur eins von mehreren konkreten Beispielen, die wir mit euch diskutieren wollen …

ENG: Big data, war, and artificial intelligence – Militarization via AI language models and ‘social’ media *DE

Speaker: Christian Heck, KHM Cologne / FIFF e.V.

Tuesday, August 26, 2025, at 4:30 p.m. in the circus tent

On March 25, 2025, the media learned about the extent of the development of artificially intelligent chatbots for military surveillance, target acquisition, and the preparation and execution of military

operations through research by journalist and filmmaker Yuval Abraham in the Palestinian-Israeli magazine +972. Since then, we have had to come to terms with the fact that AI-supported battle management and decision-making (support) systems such as “Lavender” are being used in the Gaza Strip, equipped with AI language models, where they are operated by soldiers in the same way that ChatGPT is used by civilians in their everyday lives and work. In this way, ChatGPT becomes a deadly weapon that creates a reality in which decisions about life and death are made. Big tech monopolies are thus shaping not only our everyday civilian lives, but also the crises and wars of our time. Their “intelligent” media technologies “learn” from our social media posts to calculate abstract dangers in order to prevent them preemptively. This is a dangerous security, military, and big data logic that leads to countless civilian casualties through a completely new type of technologically generated dehumanization. Victims of so-called “targeted killings” by armed drones, which are not only co-developed in Germany but also controlled from German soil.

The drone war in the War on Terror marks the starting point for a previous technologization of war, which, through civil-military (dual use) normalization, brought about aggressive and disruptive social change in civilian life. The current “Tiktokization” of hikes and mountain bike tours by drone is certainly contributing to the popularization of drone use in this “turning point in history.” Drone startups confidently present themselves as socially respected companies and enjoy double-digit billion-dollar venture capital support.

Understanding such military-civilian innovations through technologies solely in terms of their “tool” character—i.e., their use (separately) in the civilian or military sphere—leads to an inadequate analysis of society à la “technology assessment.” We must also consider the social conditions that enable the development of specific technologies in order to obtain a complete picture of the technological attack.

What does such a (comprehensive) critique of technology mean for our anti-militarist resistance on the one hand and our relationship to a (remilitarized) BigTech industry that presents itself as politically extreme right-wing to fascist on the other? The demand for a civil clause for research at universities is just one of several concrete examples we would like to discuss with you…